基本信息

- 项目名称:

- 移动机器人的视觉跟踪系统

- 来源:

- 第十二届“挑战杯”省赛作品

- 小类:

- 信息技术

- 大类:

- 科技发明制作B类

- 简介:

- 利用C++软件平台、Intel建立的开源计算机视觉开放库(OpenCV)设计并实现了一种可以跟踪场景中的红色物体的跟踪系统,该系统可以相对有效的避免场景中的光线干扰,通过计算物体轮廓重心在图像中的位置来控制机器人的转动,并根据面积的变化控制机器人的前进后退及停止。此系统可有效的在复杂的场景中跟踪物体,系统采用简单指令控制,计算量小,具有很好的鲁棒性和实时性。

- 详细介绍:

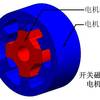

- 为了实现移动机器人系统跟踪场景中红色物体,首先上位机(联想笔记本电脑Y460)利用C++软件平台、Intel建立的开源计算机视觉开放库(OpenCV)和外加的摄像头实现目标物体(红色物体)的图像采集和识别,并处理数据形成下位机控制指令,最后通过串口传送给下位机,而下位机按接收到的指令控制电机转速和转向,实现目标物体的跟踪。 在C++软件平台中用OpenCV函数实现视频图像获取,并将图像由RGB空间转换成Lab空间,然后再提取其中的b空间视频图像,实现物体的初步剥离,再通过阈值化实现视频图像的二值化,并用中值滤波和形态学中的腐蚀、膨胀进行多次处理,以去除噪声信号,经过这一系列的操作后可实现目标物体轮廓的提取,最后利用图像的矩来确定目标物体轮廓的重心,利用OpenCV函数实现目标物体面积的计算,最后利用轮廓重心和面积两个参数来确定当前移动机器人的行动方式及相应的下位机控制指令,并通过串口传给下位机,进而实现目标物体的跟踪。 上位机实现:上位机软件程序设计是利用基于VC++平台的Intel建立的开源计算机视觉开放库(OpenCV)设计并实现这个系统。同时为了将处理过的数据通过串口传送给下位机,此上位机的软件设计中还是用了一个CSerialport类。 过程:在场景中有目标物体后,打开计算机电脑的串口和笔记本电脑自带的摄像头开始图像的采集,取得当前帧后,将此帧图像的RGB颜色空间转换成Lab空间,然后再提取其中的b空间视频图像,实现物体的初步剥离,再通过阈值化实现视频图像的二值化,并用中值滤波和形态学中的腐蚀、膨胀进行多次处理,以去除噪声信号,经过这一系列的操作后可实现目标物体轮廓的提取,最后利用图像的矩来确定目标物体轮廓的重心,利用OpenCV函数实现目标物体面积的计算,最后利用轮廓重心和面积两个参数来确定当前移动机器人的行动方式及相应的下位机控制指令,驱动下位机实现目标物体的跟踪。 下位机:下位机主要是利用单片机控制和L298N芯片驱动两路电机,实现机器人的行走。

作品专业信息

设计、发明的目的和基本思路、创新点、技术关键和主要技术指标

- 作品设计目的:随着计算机技术的不断发展,计算能力得到了极大的提高,使得利用计算机实现人类的视觉功能成为目前计算机领域中最热门的课题之一视觉跟踪(Visual tracking)问题是计算机视觉领域中的一个重要问题。视觉跟踪问题引起广泛关注是由于它能够应用于民用和军事的许多领域。视觉跟踪问题主要包括三个方面:视频监视,图像压缩和三维重构。基于这些问题而设计了此机器人视觉跟踪系统。 基本思路:为了实现移动机器人系统跟踪场景中红色物体,首先上位机(联想笔记本电脑Y460)利用C++软件平台、Intel建立的开源计算机视觉开放库(OpenCV)和外加摄像头实现目标物体(红色物体)的图像采集和识别,并处理数据形成下位机控制指令,最后通过串口传送给下位机,而下位机按接收到的指令控制电机转速和转向,实现目标物体的跟踪。 技术关键: 1)采用Lab空间b通道图像实现目标与背景的剥离。 2)上位机通过对轮廓重心和面积的提取形成简单指令控制,计算量小,实时性好。 3)利用单片机控制的L298N芯片来驱动两路电机。 参考资料: 1)侯志强,韩崇昭.视觉跟踪技术综述.自动化学报,2006,07. 2)周天娟.基于机器视觉的草莓采摘机器人技术研究.中国农业大学博士学位论文,2007,06,01. 3)彭娟春,顾立忠,苏剑波.基于Camshift 和Kalman 滤波的仿人机器人手势跟踪.上海交通大学学报,2006,07.

科学性、先进性

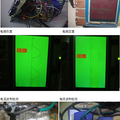

- 此机器人视觉跟踪系统是车载单摄像机跟踪单运动刚体目标系统,且是基于物体特征的跟踪系统,它是跟踪场景中的红色物体。而现在主要的分割目标物体的方法有: 1)利用Lab色彩模型中的a通道来分割目标。 2)利用Lab色彩模型中的b通道来分割目标。 3)LRCD处理方法 4)RGB模型下的色彩图像分割。 经过试验Lab空间的b通道分割方法最好,通过在b通道图像中分割红色物体,能够得到完整的物体轮廓,效果非常好,且受光照影响较小,此方法方便简单。 对于Lab空间的a通道处理方法,虽然a通道是Lab空间中绿色到红色的光谱变化,可以直接将红色物体的分割,但是受很多的相近颜色的干扰,导致分割效果差,适应性差。 对于LRCD的处理方法因为受光照影响较大,不能很到的适应环境,效果较差。对于RGB模型下的色彩图像分割对图像的处理速度快,非常简单方便,但同样受光照影响较大,不能很好的适应环境。 综合考虑Lab空间下的b通道分割场景中的红色物体的效果是最好的,实际验证也是如此。

获奖情况及鉴定结果

- 暂无

作品所处阶段

- 实验室阶段

技术转让方式

- 无

作品可展示的形式

- 1、现场演示 2、录像 3、图片

使用说明,技术特点和优势,适应范围,推广前景的技术性说明,市场分析,经济效益预测

- 该机器人视觉跟踪系统是基于物体特征的跟踪系统,用于跟踪场景中的红色物体,当场景中有红色物体时,该系统便会进行跟踪。此系统特点是使用Lab空间的b通道图像的分割算法,控制指令简单,计算量小,下位机采用L298N驱动两路电机,系统实时性较好。 同时由于此系统是基于特征的跟踪系统,所以对场景本身有一定的要求。在该场景中不能有与红色太过相近的物体,否则可能会导致跟踪失败。虽然此系统是基于Lab空间的b通道图像的分割,能够有效的避免光线的干扰,但是场景中的光线不能够太强,否则同样会跟踪失败。

同类课题研究水平概述

- 视觉跟踪,就是指对图像序列中的运动目标进行检测,提取、识别和跟踪,获得运动目标的运动参数,如位置、速度、加速度等,以及运动轨迹,从而进行进一步处理与分析,实现对运动目标的行为理解,以完成更高一级的任务。视觉跟踪问题引起广泛关注是由于它能够应用于民用和军事的许多领域,主要包括三个方面:视频监视,图像压缩和三维重构。 现在的主要的视觉跟踪算法分为基于区域的跟踪算法( region2based tracking algorithm) 、基于模型的跟踪算法(model2based tracking algorithm) 、基于特征的跟踪算法( feature2based tracking algorithm) 、基于主动轮廓的跟踪算法( active contour2based tracking al2gorithm)。 对于这些算法常用的数学方法有: 卡尔曼滤波器( Kal2man filter) 、Mean shift、粒子滤波器(particle filter) 、动态贝叶斯网络等。Mean shift方法是一种快速的、沿着梯度方向进行迭代的方法,因此能够较快地找到核密度估计的峰值(模式)。它倾向于忽略离感兴趣区域较远的数据。粒子滤波器是一种基于贝叶斯递归推理和蒙特卡洛方法的非线性系统分析工具. 粒子滤波器主要包含重要性取样和选择(再取样)。它有2个重要的成组成:动态模型和似然模型,动态模型决定粒子如何在状态空间中传播,似然模型赋予粒子权值,随后和噪声测量相关联。 虽然出现这些算法和数学方法,但是依旧有很多的问题没有解决。从控制的观点来看,视觉跟踪问题所面临的主要难点可以归结为对视觉跟踪算法在三个方面的要求,即对算法的鲁棒性、准确性和快速性要求。1)鲁棒性(Robustness)。所谓鲁棒性是指视觉跟踪算法能够在各种环境条件下实现对运动目标持续稳定的跟踪。2)准确性(Accuracy)。在视觉跟踪研究中,准确性包括两个方面,一是指对运动目标检测的准确性,另一个是指对运动目标分割的准确性。3)快速性(Speed)。一个实用的视觉跟踪系统必须能够实现对运动目标的实时跟踪,这就要求视觉跟踪算法必须具有快速性。 现在在视觉跟踪领域还有很多的问题有待解决,针对这些问题该车载摄像机跟踪单运动刚体目标系统实现了跟踪场景中的红色物体,且实时性较好。